Dunia kecerdasan buatan (AI) semakin berkembang pesat, dan salah satu pendorong utama kemajuannya adalah ketersediaan memori berkecepatan tinggi. Menjawab kebutuhan ini, Samsung baru saja mengumumkan memori HBM3E 12H DRAM dengan teknologi TC NCF yang canggih.

Artikel ini akan membahas inovasi terbaru dari Samsung ini, mulai dari teknologinya hingga potensinya dalam dunia AI.

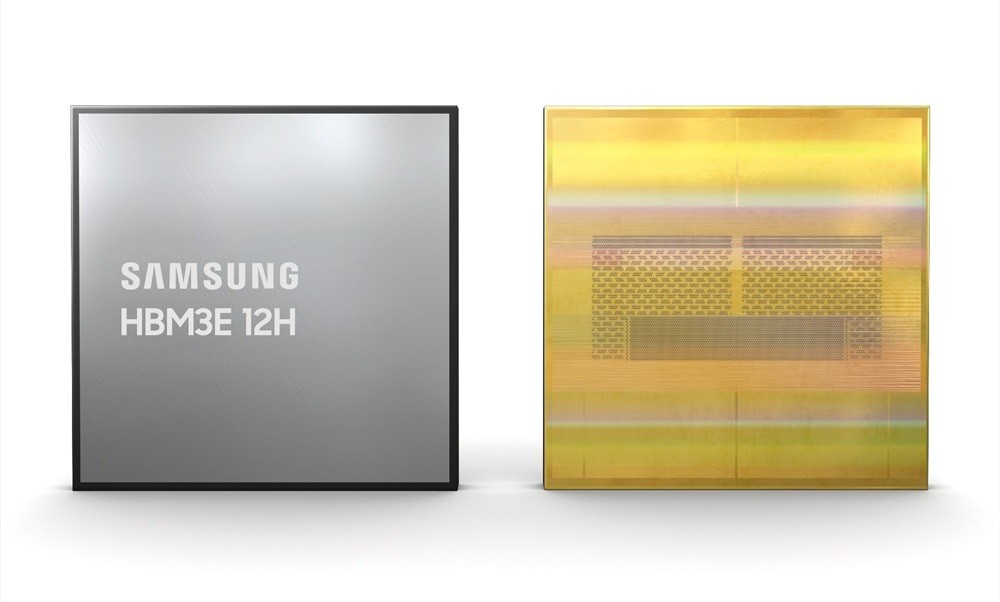

Mengenal HBM3E 12H DRAM

HBM (High Bandwidth Memory) adalah jenis memori yang dikenal dengan kecepatannya yang tinggi. Generasi terbaru, HBM3E 12H DRAM, membawa peningkatan signifikan dalam hal kapasitas.

- HBM3E Shinebolt: Diumumkan pada Oktober lalu, HBM3E Shinebolt memiliki kecepatan transfer data hingga 9.8Gbps per pin, menghasilkan bandwidth total 1.2 terabyte per detik.

- 12H: Angka ini menunjukkan jumlah chip yang ditumpuk secara vertikal dalam satu modul. Dengan 12 chip, HBM3E 12H DRAM menawarkan kapasitas 36GB, 50% lebih besar dibandingkan desain 8H.

- TC NCF (Thermal Compression Non-Conductive Film): Teknologi ini berperan sebagai lapisan tipis (7μm) di antara chip yang ditumpuk. Ketebalan yang minimal ini memungkinkan modul 12H memiliki tinggi yang sama dengan modul 8H, sehingga kompatibel dengan kemasan HBM yang ada. Selain itu, TC NCF juga meningkatkan kemampuan pendinginan dan hasil produksi.

Dampak HBM3E 12H DRAM

Kapasitas memori yang lebih besar dari HBM3E 12H DRAM akan berdampak positif pada berbagai aspek pengembangan AI:

- Pelatihan AI yang lebih cepat: Menurut estimasi Samsung, kapasitas ekstra yang ditawarkan HBM3E 12H DRAM dapat mempercepat proses pelatihan AI hingga 34%. Hal ini memungkinkan para peneliti dan developer untuk mengembangkan model AI yang lebih kompleks dan akurat dalam waktu yang lebih singkat.

- Inferensi AI yang lebih efisien: Inferensi adalah proses di mana model AI yang sudah terlatih digunakan untuk memprediksi hasil berdasarkan data baru. Dengan kapasitas yang lebih besar, HBM3E 12H DRAM memungkinkan sistem AI untuk menangani lebih banyak pengguna secara bersamaan. Samsung memperkirakan peningkatan ini bisa mencapai “lebih dari 11.5 kali lipat”.

Dengan kemampuannya tersebut, HBM3E 12H DRAM akan menjadi komponen penting dalam pengembangan berbagai aplikasi AI, mulai dari pengenalan wajah dan kendaraan otonom hingga terjemahan bahasa dan analisis medis.

Peluang Besar di Era AI

Pertumbuhan pesat AI membuat permintaan terhadap akselerator AI seperti Nvidia H200 Tensor Core GPU semakin tinggi. Akselerator ini membutuhkan memori dengan bandwidth yang sangat besar, dan HBM3E menjadi solusinya.

- Nvidia H200: GPU ini menggunakan 141GB HBM3E dengan bandwidth total 4.8 terabyte per detik. Sebagai perbandingan, kartu grafis konsumen seperti RTX 4090 hanya memiliki 24GB GDDR6 dengan bandwidth 1 terabyte per detik.

- Keunggulan HBM3E 12H DRAM: Dibandingkan dengan modul HBM3E 8H 24GB yang digunakan Nvidia H200 (total 6 modul untuk mencapai 141GB), HBM3E 12H DRAM hanya membutuhkan 4 modul untuk kapasitas yang sama. Selain itu, 6 modul HBM3E 12H DRAM bahkan dapat mencapai kapasitas hingga 216GB.

Keunggulan kapasitas dan efisiensi inilah yang membuat HBM3E 12H DRAM menjadi teknologi yang sangat diminati oleh produsen memori seperti Samsung, Micron, dan SK Hynix. Dengan semakin matangnya teknologi ini, kita dapat berharap pada perkembangan AI yang semakin pesat di masa depan.

Dengan kata lain, inovasi HBM3E 12H DRAM dari Samsung tidak hanya menawarkan peningkatan kapasitas dan kecepatan, tetapi juga berpotensi menjadi penggerak kemajuan di bidang kecerdasan buatan.